- 研究紹介インタビュー

イベントカメラの出力をもとに少ない計算量で高速に動きを認識 [CVPR2023]

イベントカメラの出力をもとに少ない計算量で高速に動きを認識 [CVPR2023]

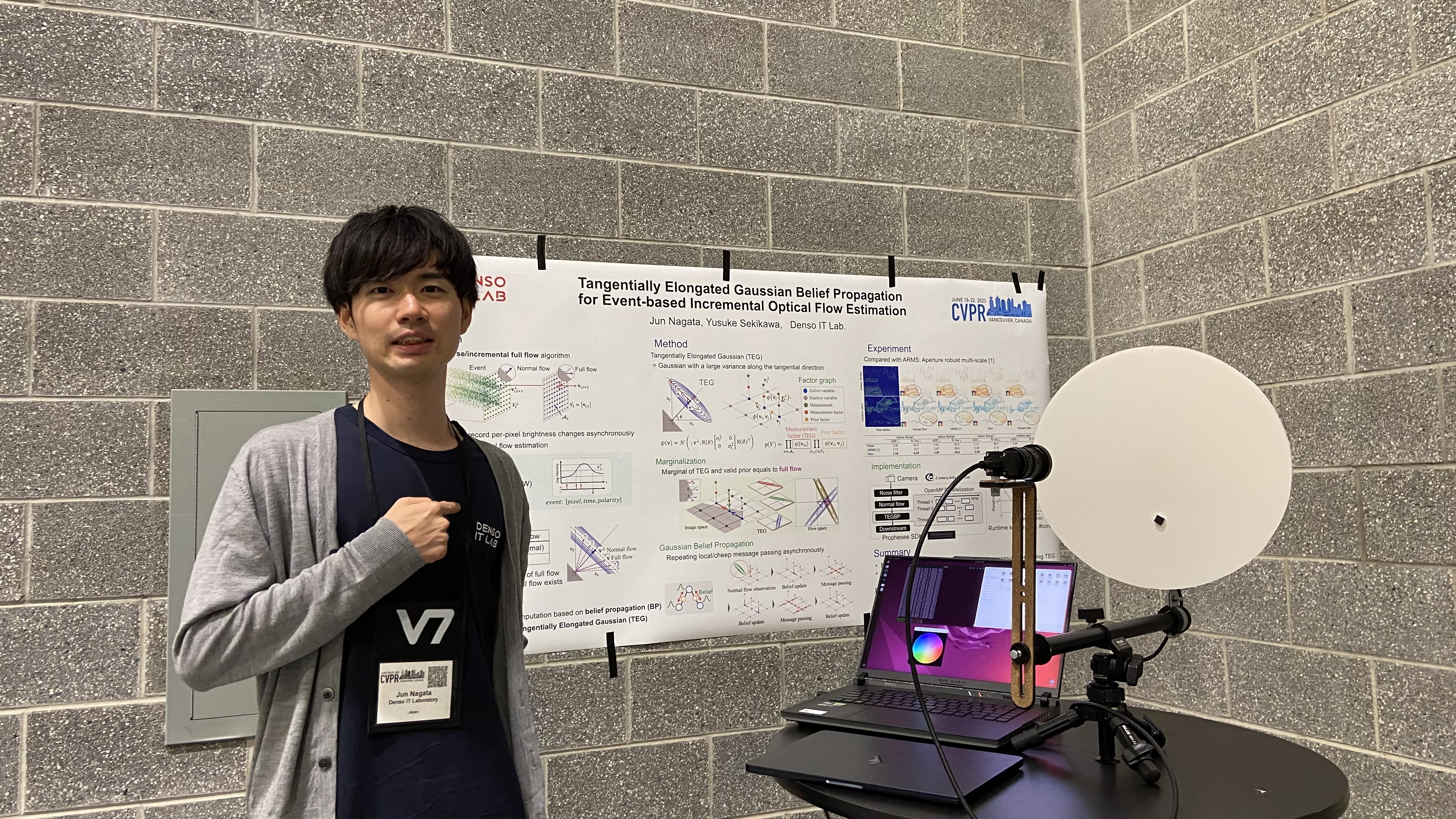

2023年6月に開催された国際会議Computer Vision and Pattern Recognition(CVPR2023)において、デンソーアイティーラボラトリの関川雄介、長田惇の共著による論文TEGBP: Tangentially Elongated Gaussian Belief Propagation for Event-based Incremental Optical Flow Estimationが採択されました。CVPRはコンピュータビジョンとパターン認識の分野で最も影響力のある国際会議の1つであり、画像認識、機械学習、コンピュータビジョンの基礎から最先端の応用に至るまで、幅広いトピックが扱われます。

本研究では、イベントカメラの出力信号を元に物体の動きを推定する新たなアルゴリズムを提案しています。論文を執筆した関川さんと長田さんに、研究の背景や成果、その意義について聞きました。

■課題:Aperture Problemを解決して、エッジの動く方向を正しく推定する

−イベントカメラというのはどういうものなのでしょうか。動体検知で画像を記録する、ペットカメラのようなものとは違うのでしょうか。

長田:撮影している範囲の中で、明るさが変化したピクセルの情報のみを記録するカメラデバイスです。市販されているペットカメラのようなフレームベースカメラは一定間隔ごとに画像をそのまま記録しますが、イベントカメラはもっとシンプルで、ピクセルごとの明るさの変化を計測し、変化が増えたか減ったか(プラスかマイナスか)のみをそのピクセルの座標と時刻とともに出力します。そのため、通常のフレームベースのカメラに比べて高速に観測を行うことができ、データ量が小さいという特長があります。実はこの動作原理は昆虫の目と似ており、また哺乳類の目の桿体(かんたい)細胞でも同様の働きをすることが知られています。

−イベントカメラを用いて物体の動きを推定するにはどうすれば良いのでしょうか。

長田:画像認識において、撮影した情報から高速・低遅延でオプティカルフロー(被写体の動く向き)を推測するのは重要な基礎技術です。従来の方法は、イベントカメラの信号を画像として扱い、ニューラルネットワークや局所的パターンマッチを用いて動きを推定するものでした。しかしこの方法ではスパースな信号データを高負荷な画像として処理するため、高速・低遅延での出力は難しくなります。そこでイベントカメラが出力するデータのスパース性をそのまま活かしたオプティカルフローの推定アルゴリズムが開発できれば、より高速で低遅延な出力が可能になります。

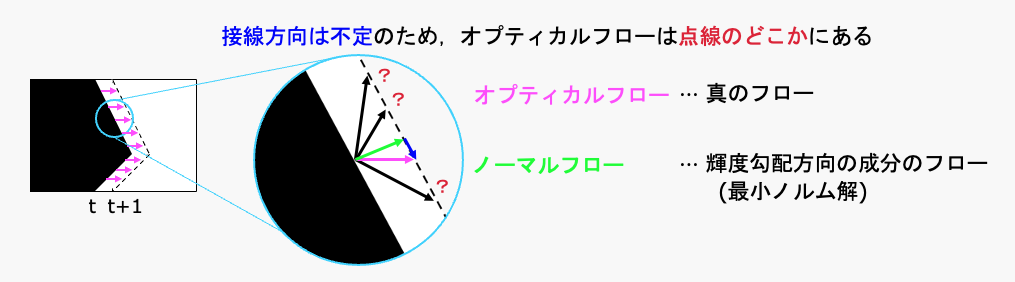

関川:スパースなデータで動きを推定する時に課題になるのが、"Aperture problem"です。一つの狭い窓(aperture)を通して物体の一部分だけを見ている場合、その物体がどの方向に動いているのか、その全体的な動きを正確に把握することができないという問題です。小さな視野の中で動くエッジを観察する場合を考えてみましょう。図1では、右に凸なエッジが、マゼンタの矢印の向きに移動しています。ここで、ブルーの丸で囲われた部分がイベントカメラの視野だと考えて下さい。時間の経過と共に物体が移動し、ピクセルの輝度はエッジと垂直な緑色の矢印の方向に徐々に暗くなっていきます。イベントカメラの出力から求められるのはマゼンタの真のフロー(オプティカルフロー)のうちエッジと垂直な輝度勾配方向の成分のフロー(ノーマルフロー)だけのため、エッジと平行方向の点線上のどこにあるかまでは決定できません。

今回提案したのは、スパースなイベントカメラのデータをスパースなまま処理して、点線上のどこにオプティカルフローがあるかを効率的に決定するアルゴリズムです。

■提案:ガウス分布で表現した観測結果を信念伝播法で周辺化

−どうやって決めるのでしょうか?

長田:オプティカルフローは、イベントカメラの出力から求められる垂直方向のフローと、エッジに沿った接線方向のフローのベクトル和になります。今回提案した方法では、オプティカルフローに対する垂直方向の僅かな測定誤差と接線方向の大きな不定性の両方を2次元ガウス分布(Tangentially Elongated Gaussian : TEG)で確率的に表現しました。TEGは、「オプティカルフローはこの確からしさでここにあるはず」という、それぞれのピクセルの信念(belief)を表現しています。イベントが発生すると、ピクセルは自身の信念を周囲のピクセルと交換します。TEGを重ね合わせて情報を周辺化していくことで、オプティカルフローを求めます。

−このアイデアを思いついたきっかけを教えて下さい

関川:イベントカメラの情報を画像化せずにスパースな信号データのまま取り扱うことで高速で効率的な処理が可能ではないかという発想からスタートしています。そのために、局所的な信念のやりとりから全体の確率分布を求めることができる信念伝播法を用いることを考えました。さらに「ノーマルフローの垂線上のどこにオプティカルフローが存在するかわからない」ということを細長く伸びたガウス分布で確率的にモデル化することで,オプティカルフローの推定を信念伝播法で取り扱える形に落とし込むことができました。また実際に実データでオプティカルフローの分布を測ってみても、ノーマルフローを中心として山になっていることが観測できたので、このモデル化が妥当であると考えました。

■評価:スパースなデータ・少ない計算量で高い精度の推定を実現

−他の方法に比べて精度はどうでしたか?

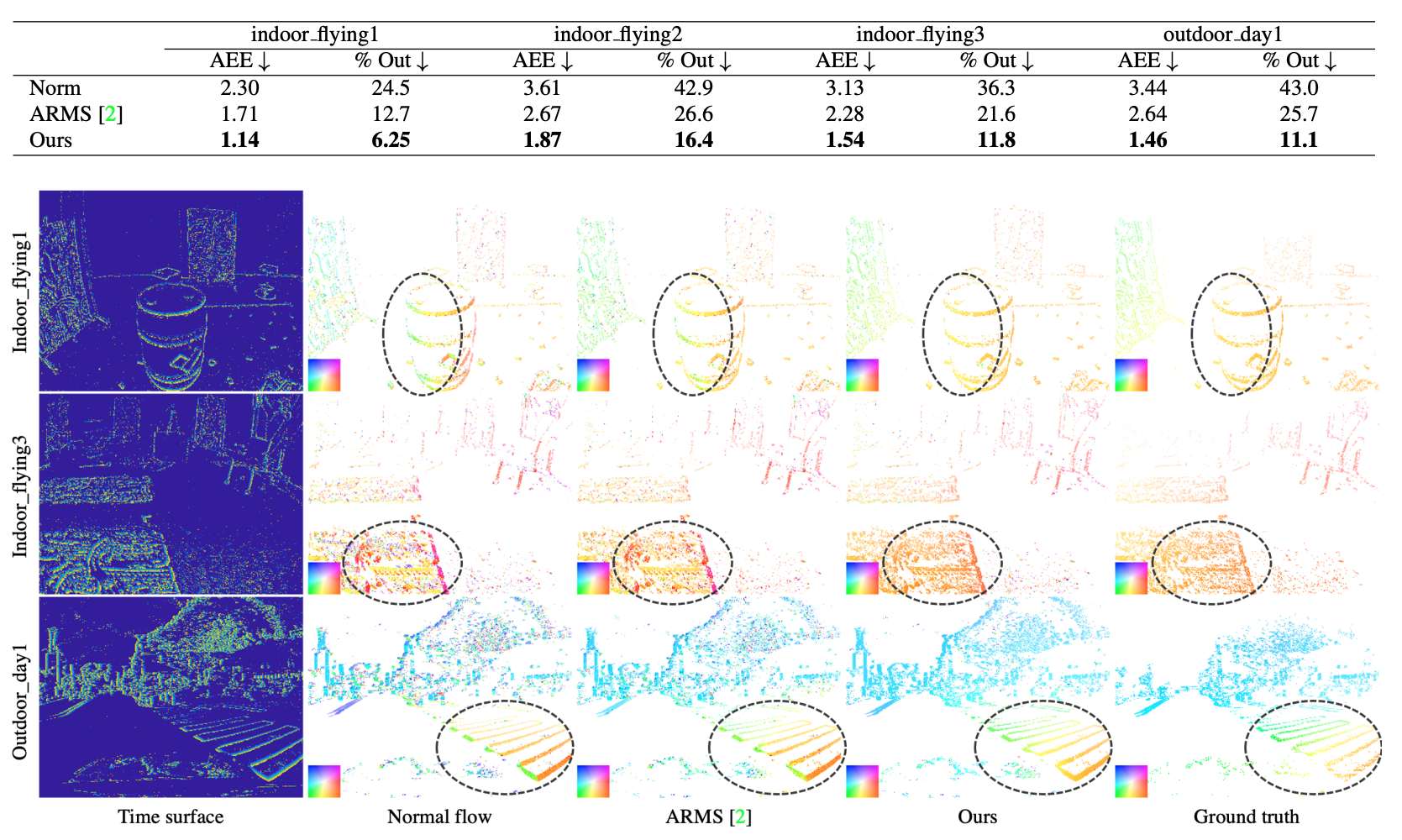

長田:論文では 4つのシチュエーションで、既存の手法と今回提案した手法で推定結果を比較しました。いずれのケースも、AEE(平均終点誤差)は大幅に改善しています。単純にノーマルフローの平均をとるだけでなくガウス分布を導入したこと、信念伝播法を導入したことでそれぞれのエッジに対応したピクセルの数が不均衡でも影響を受けにくいことが、良い結果を出せた理由だと思います。

関川:CVPR2023では、ポスターセッションだけでなくデモンストレーションも実施しました。参加した研究者からは、最近の研究はニューラルネットやディープラーニングを使って大量の計算を行うものが多いのですが、イベントカメラというスパースなデータを使って、少ない計算量で優れた結果を出せているのは良い成果だと言ってもらえました。

■今後の可能性:生物の目のような仕組みをさまざまなシーンの認識へ活用

−イベントカメラはどのようなシーンで使われているのでしょうか

長田:工業用カメラとしては既に製品化されており、火花が飛ぶ様子をモニターして溶接不良を発見したり、エンジンの振動を撮影して動きの周波数を測定し異常を検知したりする、といった用途に使われています。

溶接の火花やエンジンの振動は非常に高速なので、普通のカメラで撮影してもフレームとフレームの間に事象が発生して、連続性が途切れてしまいます。もっと時間解像度を上げるには、1万fpsクラスの高速カメラを使うという手はありますが、カメラ自体が高価ですし、処理するデータ量が膨大になるのでリアルタイムコンピューティングが難しくなります。イベントカメラはイベントが発生した時に、変化があったピクセルだけを記録するので、時間解像度が高く、データの処理も軽くなるメリットがあります。

高速にオプティカルフローが求められるようになると、高い時間解像度が必要なアプリケーションにイベントカメラの活用が進むと思います。コンシューマー製品はまだないですが、モーショントラッキングのような人の動きを高精度で測定するデバイスや、眼球の動きをリアルタイムにトレースするスマートグラスのような製品に入れていくことが考えられますね。

関川:イベントカメラが面白いのは、フレームベースの普通のカメラのようにひたすら写真を撮り続けるのではなく、生物の目のように動きがあったところだけを観測して情報を処理することで効率的に周辺の環境を認識できるところです。イベントカメラを使って物の動きが精度高く認識できるようになれば、従来のフレームベースのカメラに比べ、きめ細かな動きをタイムラグ少なく検知できるようになり、多くの人の役に立つと思います。例えば、車にイベントカメラを搭載することで従来のカメラに比べて高速かつ省エネルギーで歩行者の動きの検知が可能になるでしょう。本技術を用いることでより高速な処理が実現し、事故の低減にもつながると期待できます。

−研究成果の実用化に向けた課題を教えてください。

長田:まず、実装方法という点では、現在は解析プロセスをソフトウェアでプログラムしてCPUで実装していますが、これをFPGAやASICのようなハードウェアに載せてしまうことを検討しています。実装できればイベントカメラにチップとして搭載することで、よりコンパクトで利用しやすい、新しいデバイスが提供できます。

アルゴリズムについては、無駄なメッセージ送信を減らして計算量を減らすことと、適用範囲を広げるために制約条件を取り払う工夫が必要です。現在は、イベントカメラで観測するシーン全体が滑らかであるという仮定がありますが、これを緩めてさまざまなシーンでオプティカルフローを推定できるようにアルゴリズムを改善していきます。